열려있는 정책플랫폼 |

국가미래연구원은 폭 넓은 주제를 깊은 통찰력으로 다룹니다

※ 여기에 실린 글은 필자 개인의 의견이며 국가미래연구원(IFS)의 공식입장과는 차이가 있을 수 있습니다.

관련링크

본문

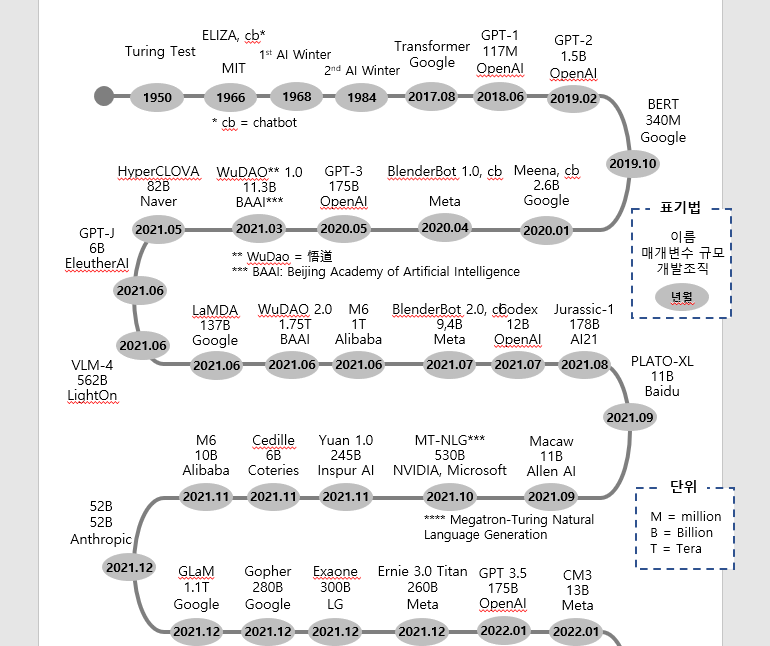

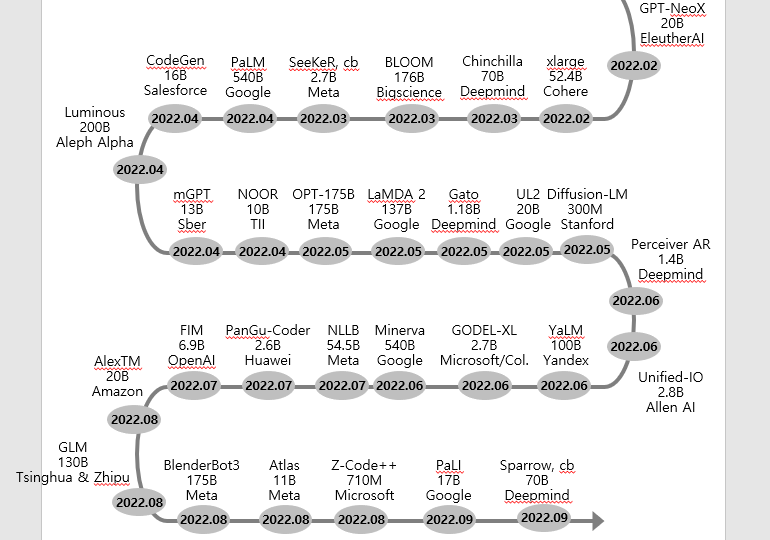

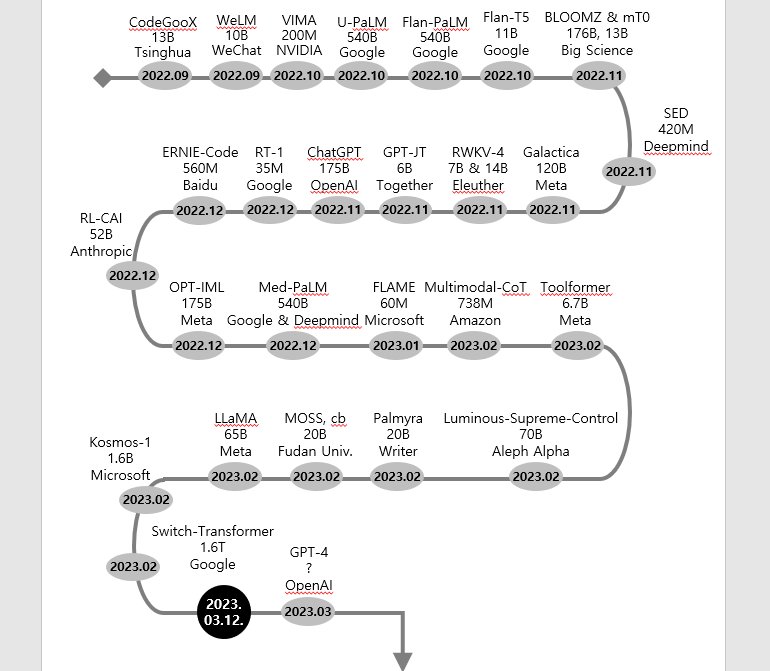

ChatGPT가 현상이 되면서, 언어모델(Language Model)과 거대언어모델(Large Language Model)에 대한 관심이 늘었다. 거대언어모델의 과거와 현재를 이해하고 미래동향을 더듬기 위해서는 거대언어모델의 역사를 확인하는 것이 필요하다. 알란 톰슨(Alan Thompson) 박사가 정리한 거대언어모델 역사를 바탕으로 오류를 수정하고 내용을 추가하여 도표를 재구성했다.

[그림 1] 거대언어모델의 과거, 현재와 미래 트렌드

[그림 2] 거대언어모델 개발 타임라인과 미래 트렌드

< 자료: Alan Thompson 박사의 자료를 기준으로 윤기영이 재구성>

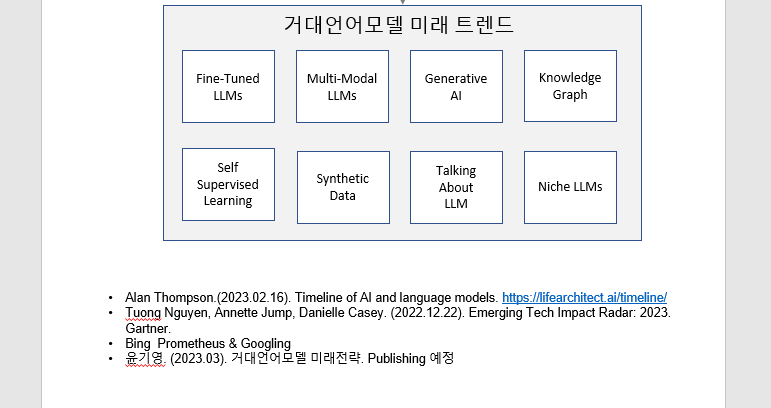

거대언어모델의 과거와 현재를 분석하면 규모의 증가, 오픈소스 거대언어모델 등장, 경쟁 심화 등으로 그 트렌드를 정리할 수 있다. 이외에 거대언어모델 트렌드를 추가로 제시했다. 이 글에서는 거대언어모델 트렌드 중 일부에 대해 다루겠다.

규모의 증가

거대언어모델의 규모란 매개변수(parameter)의 개수를 뜻한다. 인공지능의 신경망 알고리즘은 동물의 신경망에 대응한다. 신경세포는 퍼셉트론(perceptron), 시냅스는 매개변수에 대응한다. 그렇다고 이들이 동일한 것이 아니다. 매개변수의 규모가 아무리 거대해진다고 하더라도 인간의 뇌를 대체하거나 혹은 매개변수의 복잡한 네트워크 속에서 의식(consciousness)이 나타나지 않는다.

언어모델의 규모가 증가함에 따라 언어지능의 수행성이 높아졌다. 사람같이 글을 쓰거나 말을 하고, 다양한 일을 수행할 수 있게 되었다. 거대언어모델의 역사를 보면 매개변수의 규모가 급격하게 늘어나는 것을 확인할 수 있다. 최근 거대언어모델의 규모는 1조개를 넘는 것이 등장했다.

매개변수 규모가 당분간 늘어나기는 할 것이나, 계속 늘어나는 데는 한계가 있을 것으로 보인다. 구글의 TPU(Tensor Processing Unit)나 NPU(Neural Processing Unit)의 발전으로, 매개변수 규모가 증가해도 학습속도와 비용을 줄일 것으로 보인다. 미래예측을 기반으로 투자를 자문하는 Ark Invest의 2022년 보고서에 따르면, 인공지능 학습비용이 무어의 법칙보다 빠르게 하락한다고 전망했다. 문제는 매개변수를 늘린다고 해서 무조건 수행성이 높아지는 것은 아니다. 매개변수가 일정 수준 이상 증가하면 품질 등 수행성의 증가가 크지 않다.

오픈소스 거대언어모델

거대언어모델에서 오픈소스가 등장하고 있다. GPT 시리즈를 발표하고 있는 OpenAI의 설립 목적은 일반인공지능이 ‘모든 인류에게 혜택을 주도록’ 하는 것이다. OpenAI의 일반인공지능의 정의는 ‘가장 경제적으로 가치 있는 작업에서 인간을 능가하는 고도로 자율적인 시스템’을 의미하며, 전반적으로 모든 추론적 업무를 수행하는 의식 있는 기계를 뜻하지는 않는다. OpenAI는 GPT-1, GPT-2를 오픈소스로 공개하고 있다.

그 이외의 주목할 만한 거대언어모델 오픈소스로는 OPT-175B, AlexaTM, GPT-J, GPT-NeoX, Jurassic-1, CodeGen, Megatron-Turing NLG, LaMDA, BLOOM, BERT 등이 있다. 이들 오픈소스의 등장은 인공지능이 특정집단에 편향되지 않게 쓸 수 있게 하는 최소한의 방안이 된다.

Anthropic은 보다 적극적으로 보편타당한 가치를 위해 거대언어모델을 개발한다. 2021년 12월 매개변수 520억개 규모의 52B 모델을 발표하고, 2022년 52B 모델을 개선한 RL-CAI(Reinforcement Learning Constitutional AI)를 발표했다.

오픈소스 거대언어모델은 한편으로 인공지능의 민주화에 기여할 수 있다. 다른 한편으로 특정 분야에 전문성을 지닌 거대언어모델의 등장을 기대할 수 있다. 물질, 특허, 의료, 법률 분야에서의 전문성을 지닌 언어모델의 등장은 지식생산성을 높이며, 전문 서비스의 비용을 낮출 수 있다는 장점이 있다. 그러나 오픈소스가 존재한다고 하더라도 추가 학습에 막대한 비용이 든다. 관련 분야의 전문성과 품질이 좋은 충분한 텍스트를 확보하는데도 적지 않은 노력과 금융비용이 필요하기 때문이다.

거대언어모델 경쟁 심화

인간의 사고는 언어로 구성되어 있다. 서비스업과 지식산업은 언어활동이 기반을 이룬다. 사회가 진화하고 발전할수록 언어의 중요성은 더욱 커진다. 산업적 측면, 국가 경쟁의 차원에서 거대언어모델은 일종의 차별적 경쟁력 확보를 위한 지렛대 역할을 하게 된다. 이에 따라 기업단위, 국가단위에서 거대언어모델을 둘러싼 경쟁이 심화한다.

위의 거대언어모델 타임라인을 분석하면 GAMMA 중심 거대언어모델 진화와 경쟁, 중국 기업의 급격한 추격, 미·중을 제외한 국가에서의 거대언어모델 개발 참여 등의 트렌드를 확인할 수 있다.

GAMMA는 Google, Apple, Microsoft, Meta(구 Facebook), Amazon의 영문 첫머리 글자에서 가져온 용어다. GAMMA 중 거대언어모델 발전과 경쟁은 Google, Microsoft, Meta가 주도하고 있다. Apple은 위 타임라인에 등장하지 않는다. 그렇다고 Apple이 인공지능이나 거대언어모델에 관심이 없는 것은 아니다. 예를 들어 Apple의 siri는 언어모델을 전제로 한다. 그러나 애플이 어떤 언어모델을 개발하고 있는지 구체적인 정보를 확인할 수 없다. 확인하지 못한 이유는 충분한 조사를 하지 않았기 때문일 수 있다. 어떻든 Apple은 ChatGPT의 성과에 자극받아 거대언어모델 개발에 대해 재검토하고 있다는 소식은 확인할 수 있었다.

중국은 베이징 아카데미, 화웨이, 알리바바, 칭화대, 푸단대 등에서 거대언어모델을 개발했다. 베이징 아카데미를 제외하면 연속적이고 다양한 개발을 하고 있지 않으며, 거대언어모델의 규모에 집착하는 외양을 보여준다. 예를 들어 베이징 아카데미의 WuDAO 2.0은 GPT-3의 꼭 10배 규모인 1조 7500억개의 매개변수를 자랑한다.

아랍, 유럽 등에서 독자적 거대언어모델을 개발하고 있는데 이는 자연스러운 것으로 봐야 한다. 거대언어모델의 잠재력이 큰 데, 이를 GAMMA와 같은 기업이 독과점한다면, 디지털 주권이 약화하기 때문이다. 우리나라도 같다. LG는 Exaone, Naver는 HyperGLOVA를 공개했다.

전문 분야 거대언어 모델(Fine Tuned LLMs)

거대언어모델은 기본적으로 사전학습(pre-trained)된 언어모델로 추가학습이 가능하다. 추가학습(fine-tunning)이란 특허, 의료, 법률, 회계, 과학 등의 추가 학습이 가능하다는 의미다. 추가학습을 통해 거대언어모델의 활용분야는 다양하게 확장될 수 있다.

추가학습의 한 유형으로 특정 보험사의 보험업무에 대한 추가학습이 가능할 수 있다. 보험사의 콜센터, 보험 리스크 관리자, 원격 보험 영업 등을 거대언어모델이 담당할 수 있다. 정확하게는 이들 거대언어모델을 증강지능의 역할을 맡을 것이고, 이들 증강지능의 도움을 받은 콜센터 직원 등의 생산성이 늘어나게 될 것이다. 과거와 같은 수의 콜센터 직원은 필요 없을 것이며, 대신 거대언어모델이 보험사 업무를 추가학습하는 데 보조하는 저임금의 일자리, 거대언어모델과 하드웨어를 관리하는 극소수의 일자리가 늘어나며, 그에 비례하여 거대언어모델 소유 기업의 이윤이 막대하게 증가할 것이다.

언어와 기호와 관련된 다수의 업무에서 거대언어모델의 전문분야가 확장될 것이다. ChatGPT의 거품이 꺼지고 실망하는 때가 오겠으나, 다양한 언어모델의 경쟁 속에서 경쟁력 있는 언어모델이 등장하게 될 것이다. 지금도 그렇지만 경쟁력 있는 언어모델의 등장으로 거의 모든 분야에 거대언어모델이 침투할 것이다.

다양한 매체로 소통하는 거대언어 모델(Multi-Modal LLMs)

인공지능에 있어서 Multi-Modal이란 언어뿐만 아니라 소리와 이미지 등으로도 사람과 소통하는 인공지능을 의미한다. 이는 입력과 출력을 모두 포함한다. Deepmind의 Gato는 언어로 지시하면 로봇 팔을 움직일 수 있다. Amazon의 Multimodal-CoT는 이 Multi-Modal을 위한 거대언어모델에 속한다. 3월 중순에 발표될 예정인 GPT-4는 Multi-Modal에 집중한 것으로 전망된다.

Multi-Modal은 일반인공지능(AGI, Artificial General Intelligence)으로 가는 여정이다. 이때 일반인공지능이란 인간과 같이 어떠한 지적 작업을 이해하거나 배울 수 있는 기계지능을 뜻한다. 그림을 그리고 운전하며 요리를 하고 싶은 쓸 수 있는 등 다양한 인지와 지적 활동을 할 수 있는 인공지능이 일반인공지능이다. 그러기 위해서는 Multi-Modal이 있어야 한다.

완전한 일반인공지능이 인공지능 개발의 목적은 아니며, 과학기술이 발전한다고 하더라도 그러한 기술이 달성되는 것은 요원할 수 있다. 어떤 인공지능 전문가의 주장에 따르면 일반인공지능이 실현되는 때는 ‘20년 이내, 2000년 이전’일 것이다. 그의 주장에는 충분히 공감한다.

Multi-Modal이 성숙하면서 인공지능이 할 수 있는 인지노동의 범위는 확대될 것으로 보인다. 그 범위가 확대되는 만큼 경제적 유인이 크다. 이미 Multi-Modal을 실현하기 위한 경쟁이 시작되었다.

그 밖의 동향들

거대언어모델의 논리력은 약하다. 논리력을 높이기 위한 사고 연계 프롬프트 기술인 Chain-of-Thoughts에 대한 실험적 접근이 늘 것이다. 인공지능의 신경망 알고리즘에서 피하기 어려운 환각(Hallucination)을 줄이기 위한 다양한 시도와 접근 늘 것이다. 지식 그래프(Knowledge Graph)는 그러한 노력의 하나가 될 것이다.

인공지능이 스스로 지도학습하는 Self-Supervising Learning 기술에 대해서도 투자가 늘 것이다. 인공지능 학습비용괴 기간을 줄일 수 있기 때문이다. 거대언어모델을 넘어서는 생성 인공지능이 본격적으로 관심을 이끌 것이다.

그 밖에 거대언어모델 학습비용 하락, 탄소발자국을 줄이는 노력 등이 다양하게 진행될 것이다.

이들 동향과 정치, 경제, 사회 등의 동향이 어울려 거대언어모델로 인한 미래가 만들어질 것이며, 그러한 변화를 더듬어 미래전략을 글로벌 차원, 국가 차원, 기업 차원 및 개인 차원에서 수립해야 한다. 눈 앞을 가리는 거대한 ChatGPT가 주는 희망과 기대에 매몰되지 않으려면 더욱 그래야 한다. 그러기 위해서는 수평선 너머를 더듬을 수 있어야 한다. 높이 올라 멀리 바라봐야 한다. 이 글을 읽은 모든 분이 그래야 한다.

<ifsPOST>

- 기사입력 2023년03월15일 17시10분

- 최종수정 2023년03월16일 10시51분

댓글목록

등록된 댓글이 없습니다.